AI看病,你放心吗?关键得看看这些……

来源:国家卫生健康委员会2025-03-25 18:38:22

国产大模型DeepSeek引发的AI话题席卷各行各业。AI在医疗领域表现如何呢?AI看病行不行?

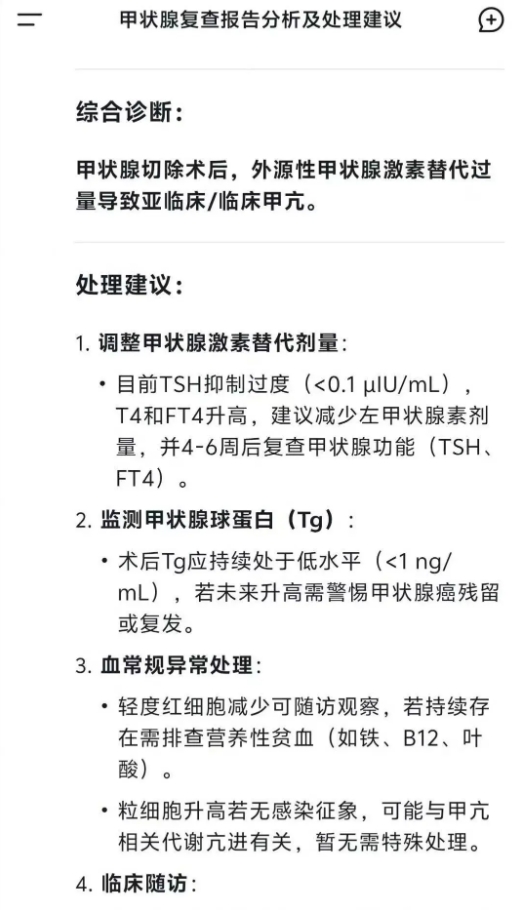

有家长们晒出与AI的对话记录:“孩子血常规指标异常,DeepSeek的建议与三甲医院主任医师的诊断一致”。一位肺部结节患者表示"AI系统不仅快速识别出结节,还给出了详细的良恶性分析,最终与医生的诊断高度一致"。也有家长分享,AI为患有慢性疾病的家人提供了个性化的健康管理建议,甚至比医生更早发现潜在风险。

在医院里,有患者手持AI生成的诊断报告前来问诊,甚至要求医生“按AI方案开药”。

有患者说“DeepSeek的诊断和医生一模一样!”的,但也有的表示:“AI再厉害也是机器,医生的判断和经验才是关键”。不少医生都对AI赞不绝口,已经应用到临川工作了。

随着关于AI相关讨论的快速升温,无论医生还是患者,核心关注的问题可能是:AI看病,你放心吗?

2024年11月,国家卫生健康委发布了《卫生健康行业人工智能应用场景参考指引》,明确提出84个AI在医疗领域的应用场景,涵盖预防、诊断、治疗和康复等全流程。这一政策为AI在医疗领域的应用提供了明确的方向和规范,显示出国家对AI技术在医疗领域应用的积极支持态度。

然而,政策的支持并不意味着对AI的完全信任。湖南省医疗保障局明确禁止AI自动生成处方,强调医生开具处方必须与患者进行充分沟通。

据不完全统计,全国已有90余家医院接入DeepSeek,覆盖ICU、急诊、影像科等多个关键场景。据报道,上海瑞金医院引入DeepSeek系统后,呼吸系统疾病的诊断准确率提升至93.7%,显著缩短了患者的黄金治疗窗口期。首都医科大学附属北京天坛医院推出的“龙影”大模型(RadGPT)可以在0.8秒内生成针对多种疾病的诊断意见。

使用一件工具是否顺手、安心,关键还是得深入了解,只有足够了解,才能在使用中“张弛有度”,一起从以下几个方面来看看吧。

AI诊断依据从何来?

AI诊断的准确性与可靠性,很大程度上取决于其训练数据和算法设计。目前,AI诊断依据主要来自以下几个方面:

海量医疗数据的训练

AI模型通过分析大量的医疗数据,包括病历、医学影像、实验室检查结果等,学习疾病特征与诊断结果之间的关联。一些AI模型在医学影像分析中表现出色,能够识别出微小的病变,超越了人眼的极限。此外,AI在处理结构化数据时,能够快速提取关键信息,辅助医生进行诊断。

医学文献与临床指南

AI系统会参考大量的医学文献和临床指南,这些资料为AI提供了标准化的诊断流程和参考标准,以提供符合医学规范的诊断建议。

专家经验与知识整合

一些AI模型还会整合专家的经验和知识。例如,通过模拟真实诊疗场景,AI可以学习专家的诊断思路和决策过程。这种结合专家经验和数据驱动的方法,使AI在处理非典型病例时也具备一定的能力。

多维度数据融合

现代AI诊断系统不仅依赖单一数据源,还会融合多种数据类型,一定程度上也能做到结合患者的症状描述、检查结果和影像学信息,更全面地评估病情。这种多维度的数据融合,使得AI在某些复杂疾病的诊断中表现出色。

但尽管AI在诊断依据的获取和处理上具有优势,但其局限性也不容忽视。首先,AI依靠模型的训练数据,建模的数据往往决定了AI的整合“算力”,不同AI存在“算力”上的参差不齐。其次,面对数据缺乏的罕见病非典型病例时,由于历史数据相对缺乏,容易出现误判。此外,AI缺乏医生的临床经验和人文关怀,无法完全替代人类医生的判断。

“算力”无敌,但“诊治”≠算力

AI的超强算力确实让人惊叹。它能够在短时间内处理海量数据,快速生成诊断结果,在某些影像诊断中,准确率高达95%以上。然而,看病和诊疗过程远比单纯的算力输出复杂得多。医疗诊断不仅仅是数据分析,更是对患者整体状况的综合判断,这其中蕴含着传统中医“望闻问切”的智慧,也包含着现代医学对患者个体差异的细致考量。

“望”是医生对患者外在表现的观察,而“闻”则是通过与患者的交流获取关键信息。AI虽然可以通过自然语言处理技术与患者对话,但在真实医疗场景中,其对话诊断的准确性却大打折扣。例如,研究显示,即使是最先进的AI模型,在模拟患者访谈时的诊断准确率也仅有26%。这是因为AI难以像医生一样通过察言观色捕捉患者的情绪和细微变化,也无法在交流中灵活调整问诊方向,从而错过关键线索。

“问”和“切”则更依赖医生的临床经验和对患者身体状况的直接感知。AI无法像医生一样通过触诊感知患者的脉搏、肿块的质地,也无法通过观察患者的反应来判断病情的轻重。而医疗诊断还需要考虑患者的个体差异、心理状态、社会背景等多方面因素。

长枪还是短剑,还看“握”在谁手里

AI本身是一个强大的工具,但它的作用程度却因使用者的不同而千差万别。无论是医生还是普通人,AI在他们手中发挥的作用和价值都取决于使用者的能力和经验。

作为医生,你是否放心用AI给患者看病?

对医生而言,AI既可以是强大的助手,也可能成为干扰因素。有研究显示,AI在辅助诊断时的效果因医生的个人差异而异。哈佛大学医学院和斯坦福大学的研究表明,AI工具对放射科医生的影响并不一致,部分医生的表现因AI而提升,而另一些医生的表现则可能“恶化”。

AI的使用效果受到医生的专业背景、经验以及对AI的理解和运用能力的影响。经验丰富的医生能够更好地利用AI提供的数据和建议,将其融入自己的诊断逻辑中,从而提升诊断的准确性和效率;而缺乏经验的医生可能会过度依赖AI,甚至被误导。

作为普通人,自己用AI看病能否安心?

对于普通人来说,AI的使用效果则更为复杂。AI的诊断高度依赖用户输入的信息,而普通人往往缺乏专业的医学知识和表达能力,信息传达的准确性是一大挑战。如果输入信息不准确或不完整,AI的诊断结果可能会出现较大偏差,甚至给出完全错误的建议。

信息表达模糊导致误判:比如,患者仅输入“我感觉不舒服”,却没有详细说明具体症状、持续时间或相关背景信息。AI系统因缺乏关键细节,只能给出宽泛的建议。

症状描述不全面引发误导:如患者因胸痛咨询AI,却未提及自身高血压、心脏病史,AI可能误判为普通肌肉拉伤,忽略潜在心脏问题,导致患者错过最佳治疗时机。

缺乏个性化评估:AI在处理复杂病情时,难以像医生一样综合考虑多种因素及捕捉关键信息,同时缺乏个性化考量。

普通人对医学术语和症状描述的不熟悉,使得他们在使用AI系统时,往往难以准确表达自己的健康状况。可能遗漏关键信息,或者使用模糊的描述,导致AI系统无法获取足够的细节来进行精准诊断。

简而言之,抛开不同AI的“算力”上的差别,其问诊的准确度,还跟信息的准确输入与输出信息的准确理解息息相关。

AI本质上是工具属性,工具能不断迭代升级、超越人力的极限,但终究人是工具的使用者。AI看病是否可行呢,放眼未来一定“大有可为”,但使用者必须始终抱着“不放心”的态度,多思量、多权衡便可最大程度地“放心”。

CHTV 百姓健康微信

CHTV 百姓健康微信